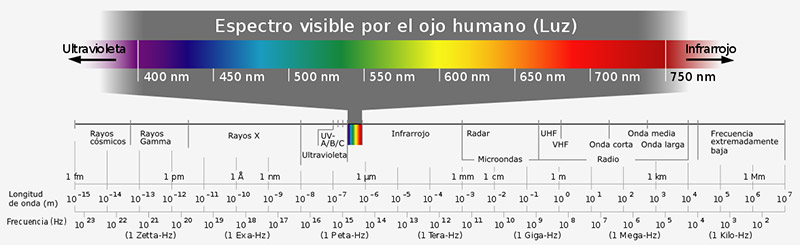

Vol. 19, núm. 2 marzo-abril 2018

Cultura graffitera brasileña

Marco Tulio Pedroza Amarillas CitaResumen

En este artículo se describe la vivencia de internarse en la cultura graffitera brasileña a través de un recorrido por Rio de Janeiro, Curitiba, Feira de Santana, Salvador y Recife, cinco ciudades en donde nos encontramos por primera vez con tan imponente cultura. Mediante la investigación de campo, conversamos a profundidad con los sujetos que la conforman y comprendimos que la cultura graffitera brasileña se integra por dos culturas diversas entre si: la pixação y el graffiti de escritores. Una de las características más importantes de la cultura graffitera brasileña es que está constituida por las dos culturas mencionadas, y que simultáneamente en cada estado, en cada ciudad, en cada barrio, ambas culturas se diversifican aún más a través de las particularidades de cada uno de los sujetos que la practican.

Palabras clave: Brasil, graffiti, pixação.

Brazilian graffiti culture

Abstract

This article describes the experience of entering the Brazilian graffiti culture through a tour of Rio de Janeiro, Curitiba, Feira de Santana, Salvador and Recife, five cities where we find ourselves for the first time with such an impressive culture. Through field research, we talked in depth with the subjects that comprise it and we understood that the Brazilian graffiti culture is integrated by two different cultures: the pixação and the graffiti of writers. One of the most important characteristics of the Brazilian graffiti culture is that it is constituted by the two cultures mentioned, and that simultaneously in each state, in each city, in each neighborhood, both cultures are further diversified through the particularities of each one of the subjects that practice it.

Keywords: Brazil, graffiti, pixação.

Entre graffiti de escritores y pixação

Nuestro interés por el graffiti surge con el inicio del siglo XXI, un análisis del graffiti de escritores en la Ciudad de México junto con las identidades que genera fue el resultado de nuestra primera investigación (Pedroza, 2010). Dando continuidad a este tema, en una segunda investigación (Pedroza, 2012) definimos las características visuales de este tipo de graffiti en la misma ciudad. A partir del año 2014 tuvimos la oportunidad de investigar la cultura del graffiti de escritores y la pixação en distintas ciudades brasileñas. Como resultado de esta tercera investigación (Pedroza, 2016), realizamos un análisis comparativo entre las culturas del graffiti de escritores en México y Brasil. El artículo que el lector tiene entre sus manos presenta parcialmente los resultados de esta última investigación.

En 2014 realizamos nuestras primeras visitas a Brasil a través de las cuales percibimos dos culturas urbanas alternativas que se articulan: 1) la pixação y 2) el graffiti de escritores. Ambas se unen entre ellas, y simultáneamente a la cultura planetaria del graffiti de escritores. Para el año 2015 realizamos un período de dos meses de trabajo de campo durante el cual asistimos a importantes festivales dentro del calendario anual del graffiti brasileño. En este período convivimos con una cantidad significativa de escritores de graffiti y de pixadores originarios tanto de las cinco ciudades que visitamos (Rio de Janeiro, Curitiba, Feira de Santana, Salvador y Recife) como del resto de Brasil.

En nuestro planeta existen diversas identidades derivadas de la utilización de tags por parte de los sujetos para diferenciarse. A partir del surgimiento del tagging y del bombing neoyorquino en la década de 1960, la caligrafía urbana ha sido concebida como un estilo de vida para distintas culturas urbanas alternativas. Como es sabido, la escritura urbana se ha realizado a lo largo de la historia de la humanidad; sin embargo, sólo actualmente, es vivida como una identidad practicada en todo el planeta. El caso de Brasil es interesante pues la caligrafía urbana ha generado distintas identidades entre las que destacan la de los pixadores y la de los escritores de graffiti.

Los estilos que utilizan los escritores de graffiti en Brasil, son los utilizados actualmente por los graffiteros de todo el planeta. Algunos de los más utilizados en orden de aparición e importancia son: tag (o firma), escurrido (o drip), bomba (o bubble-letter), throw-ups (o vomitados), pieza (o piece), carácter (o character), 3-D (o three-D), wild-style (o estilo salvaje), top-to-bottom (o de arriba abajo), y producciones. Un tag es la firma de un escritor de graffiti, realizada de manera muy estilizada, veloz y por lo regular con un solo color de tinta o pintura. De este estilo de escritura de graffiti fueron derivando los otros que hemos mencionado.

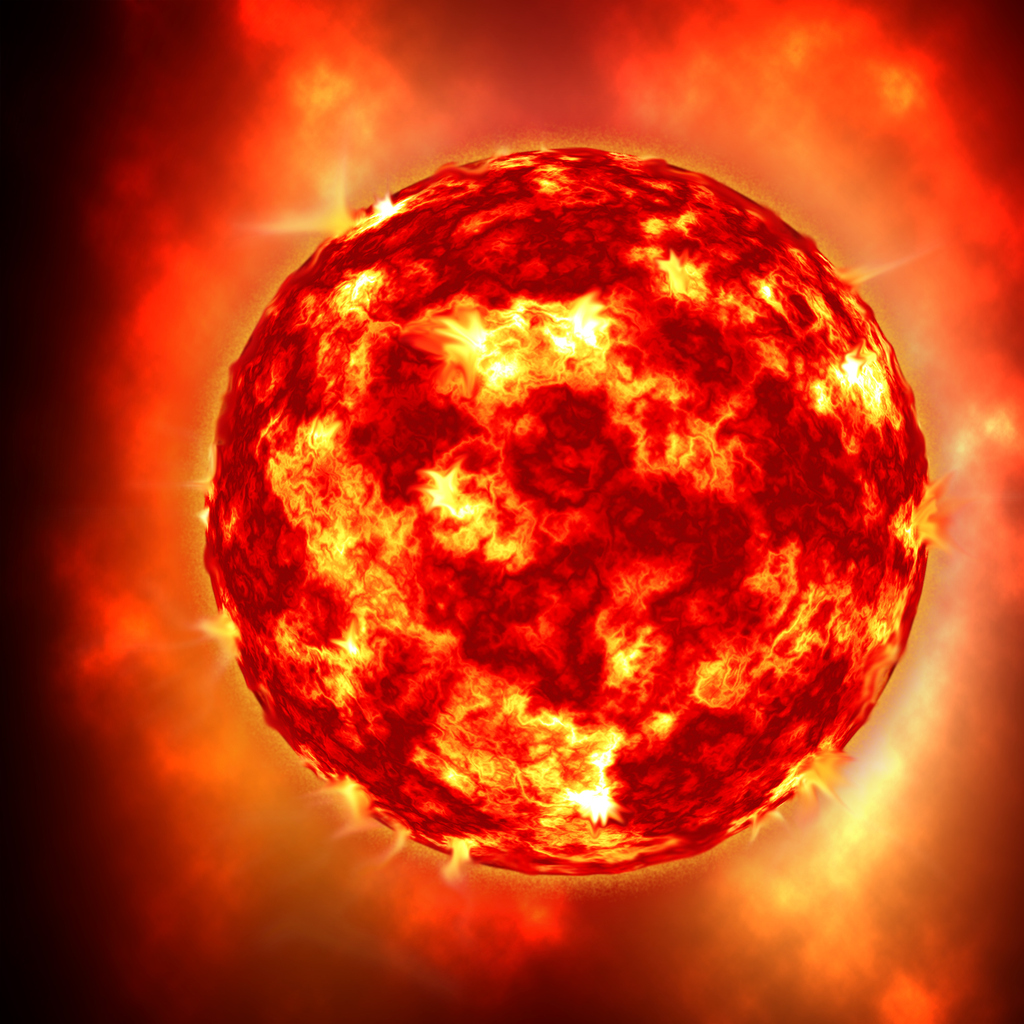

Imagen 1. Graffiti de escritores, Curitiba, 11/09/14.

Producción realizada en Curitiba con caracteres (personajes) por los escritores de graffiti (de izquierda a derecha) AUMA originario de Curitiba, COF originario de Argentina, JAPEM originario de Curitiba, ACRA originario de Argentina y STEEP originario de Colombia, empleando pinturas en aerosol sobre muro con recubrimiento de concreto. Fuente: Pedroza Amarillas, Marco Tulio (2014).

Pixação es un estilo de graffiti exclusivo de Brasil, una cultura de escritura urbana alternativa basada en la ejecución de firmas sobre la ciudad entera y más allá. Los pixadores asocian la pixação a firmar, marcar, manchar, pero principalmente a la protesta y a la trasgresión. La pixação trasgrede la imagen visual de la mayoría de los espacios públicos de las ciudades por todo Brasil. Su estética trasgrede la estética hegemónica, dicha trasgresión implica firmar excesivamente todo lo que los pixadores encuentran a su paso, razón por la que está criminalizada.

La pixação puede ser definida casi en los mismos términos que el tagging, pues se realiza exclusivamente en condiciones ilegales de producción. Al igual que sucede entre los escritores de graffiti, los pixadores utilizan un tag en forma de apodo, alias o pseudónimo, y mantienen con él la relación que se tiene con un nombre propio. Este tag, deviene en un mecanismo que otorga al pixador una identidad pública, que le garantiza el anonimato hacia el exterior de su cultura y simultáneamente gana el reconocimiento de sus trabajos hacia el interior, esto puede ser expresado en distintos casos como: fama, prestigio, admiración o respeto.

En otro artículo (Pedroza, 2016) hemos realizado una tipología de los estilos de la pixação, la cual se originó en distintas ciudades brasileñas en la década de 1960 y se ha seguido desdoblando hasta la actualidad. Algunos de los estilos más utilizados en orden de aparición en la cultura de los pixadores son: pixo o pixação, tag recto, eternos, grapixo o pixo contorneado. Xarpi es una palabra utilizada exclusivamente entre los pixadores para referirse a la pixação, xarpi es pixar pronunciado al revés.

Rio de Janeiro

La ciudad de Rio de Janeiro, como cualquier entorno urbano, alberga una diversidad de culturas, y como entorno urbano brasileño alberga necesariamente las culturas urbanas alternativas de la pixação y el graffiti de escritores. Comenzamos dimensionar la diversidad en la pixação y el graffiti brasileño a través de las charlas que tuvimos Gustavo Coelho quien en 2011 dirigió el video documental Luz, Câmera, Pichação. Coelho explica que existen diferencias entre la pixação de las ciudades de Rio de Janeiro y São Paulo, esas diferencias se refieren principalmente a las características de las tipografías utilizadas por los pixadores de cada ciudad. En São Paulo las caligrafías son rectilíneas y de grandes dimensiones, en Rio de Janeiro las caligrafías son curvilíneas y con dimensiones menores.

BOBI fue el primer graffitero que conocimos personalmente en Brasil durante nuestra primera visita a la ciudad de Rio Janeiro en septiembre de 2014, él nos presentó a otros escritores de graffiti de la ciudad: KAJAMAN y NEXT2. Estos tres graffiteros forman parte de la organización de uno de los festivales mas importantes de esta ciudad, ellos lo definen como el mayor evento de graffiti voluntario del mundo: Meeting of Favela (MOF). MOF surge como contraposición al festival internacional nacido en Alemania llamado Meeting of Styles (MOS) en el que la única manera de participar es mediante carta de invitación. Volvimos a Rio de Janeiro en noviembre de 2014 a presenciar la novena edición del MOF en Villa Operaria, en Duque de Caxias, Rio de Janeiro, en ella pudimos apreciar el diálogo y la interacción cultural que graffiteros de todo Brasil y de otros países tienen con esta ciudad.

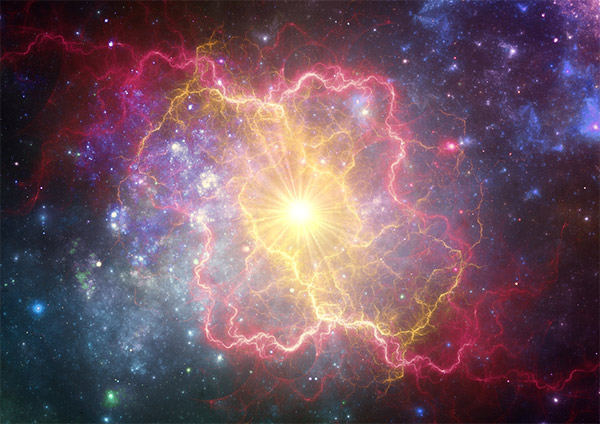

Imagen 2. Pixação, Curitiba, 10/09/14.

Imagen 2. Pixação, Curitiba, 10/09/14.

Tags rectos realizados por pixadores desconocidos utilizando

pintura látex y rodillo sobre muro con recubrimiento de concreto.

Fuente: Pedroza Amarillas, Marco Tulio (2014).

Curitiba

Curitiba fue la segunda ciudad brasileña que conocimos en 2014, como en los otros escenarios urbanos investigados, la pixação y el graffiti de escritores se articulan con todas las culturas que conforman la ciudad. AUMA fue el primer graffitero brasileño que contactamos desde México, pudimos hacerlo gracias a EKER quien es el ejecutivo de ventas de la marca mexicana de pinturas en aerosol Ilegal Skuad. Posteriormente, EKER, nos puso en contacto con José Ángelo da Silva y Ana Luisa Fayet Sallas. Una pareja de sociólogos quienes también investigan la cultura de los escritores de graffiti en México, ambos imparten cátedra en la Universidad Federal do Paraná y en el Colegio de México.

Gracias AUMA tuvimos la oportunidad de documentar las prácticas y las narrativas de: TOM 14, graffitero curitibano quien vivió en la ciudad de Guadalajara, México; de CAFE, otro graffitero curitibano que gusta de imprimir en sus trabajos la temática de la cultura africana; de los pixadores GRYPE, LINGÜIÇA y BIDU, quienes paradójicamente practican indiscriminadamente la pixação y en algunas ocasiones el graffiti de escritores.

A través de AUMA conocimos a CIMPLES, uno de los pixadores más antiguos de la ciudad quien abandonó la práctica de la pixação por la de las Artes Visuales. CIMPLES definió la pixação de Rio de Janeiro por su pequeño tamaño y letras curveadas; la de São Paulo por su tamaño grande, y sus letras rectas y anguladas; y la de Curitiba por sus letras mas rectas y grandes que en São Paulo.

DAVIS, otro de los graffiteros curitibanos que conocimos mediante AUMA, comenzó practicando la pixação para posteriormente dedicarse a la práctica del graffiti de escritores exclusivamente. Es la cabeza de la organización del festival de graffiti curitibano Street of Styles y dueño de Capsula graffiti Shop. En 2015 volvimos a Curitiba para presenciar el festival, que al igual que el MOF también se opone al MOS.

Feira de Santana y Salvador, Bahia

En nuestro primer acercamiento a las culturas de la pixação y del graffiti brasileños, es decir, en 2014, tuvimos la oportunidad de asistir al 2º Encontro de graffiti de Feira de Santana, Bahia. Conocimos este encuentro gracias a BOBI, quien también nos presentó a graffiteros como KAJAMAN, NEXT2 y Heitor Corrêa de Rio de Janeiro; BIGOD, NOTEM, VIDAL, FUMAX, KBÇA, PIPIPNO, FTX y Julio Costa de Salvador, Bahía; MAO de São Paulo, CHERMIE de Amazonas, DEZA de Recife; y CAMELO y DNIELLE de Teresina, Piauí.

Después del encuentro conocimos el centro de Salvador y la Ladeira da Preguiça, donde los graffiteros locales realizan intervenciones constantemente. En esa ocasión se realizó una producción entre varios graffiteros que participaron días antes en el encuentro de Feira de Santana. En este lugar, conocimos a SINS un graffitero nacido en Australia quien fue el primero en establecer en Salvador, Bahia, una tienda especializada en graffiti.

A nuestro regreso en 2015 pudimos documentar la creación del festival de graffiti “Bahia de Todas as Cores” (BTC), el cual articuló la celebración de una reunión nacional de escritores de graffiti con un amplio programa de actividades y eventos de interés cultural-artístico que tuvieron lugar en diversos espacios públicos en la ciudad de Salvador, Bahia y más tarde en otros municipios. La primera edición del BTC, con sede en Salvador, se celebró los días 12 al 15 de marzo de 2015, este festival ya está considerado dentro del calendario anual de festivales de graffiti en Brasil.

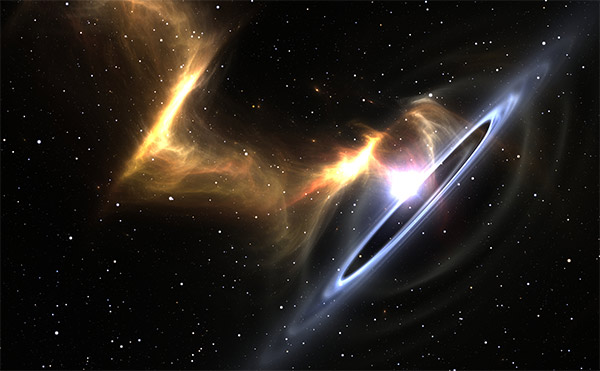

Imagen 3. Pixação, Curitiba, 10/09/14.

Imagen 3. Pixação, Curitiba, 10/09/14.

Grapixo o pixo contorneado realizado por POBRES Crew, pixadores originarios de la

ciudad de Curitiba, utilizando pintura látex y rodillo sobre muro recubierto de concreto.

Fuente: Pedroza Amarillas, Marco Tulio (2014).

Recife

La última ciudad de Brasil que conocimos durante el trabajo de campo en marzo de 2015 fue Recife, acudimos a presenciar la 7ª edición del festival denominado Recifussion (RF7). Fuimos invitados a este festival por Nika Dias, integrante de la 33 Crew responsable de la realización de Recifussion. En el festival internacional de graffiti RF7 conocimos a otros destacados integrantes de la 33 crew como JOHNY C y AREM. Además de asistir al festival, simultáneamente pudimos conocer el barrio de Pina y el trabajo que realizan algunos pixadores locales para luchar contra el consumo de drogas y para fomentar la interacción de la comunidad.

En este importante acercamiento conocimos a los pixadores SHELLDER, STILO, MENOR, BOLADO, TAB e INSANO, quienes paradójicamente también son escritores de graffiti. Estos pixadores-escritores de graffiti pertenecientes a las Crews OSMO (Os Mais Odiados), ADP (Anarquistas Detonadores da pixação), 100 Parar (Sem Parar) y VQ (Varias Queixas), realizan un servicio social llevando graffiti a las comunidades menos favorecidas de esta ciudad. Dichas comunidades se encuentran en la periferia de la Favela de Bode y se componen de construcciones a las que denominan palafitas, las cuales son edificadas con madera y materiales reciclados a las márgenes del río. A esta acción de realizar graffiti de escritores en las comunidades constituidas por palafitas la han denominado Palaffiti.

Consideraciones finales

Como mencionamos al inicio, este artículo muestra parcialmente los resultados de nuestra tercera investigación (Pedroza, 2016) acerca del tema. Para realizarla utilizamos la propuesta epistemológica de Haidar (2006), de la cual utilizamos como ejes teóricos: la Epistemología de la Complejidad (Morin) y la Semiótica de la Cultura (Lotman). A partir de los ejes mencionados analizamos la cultura urbana alternativa de los graffiteros como una cultura planetaria. Consideramos que la cultura del graffiti de escritores comenzó a consolidarse en Brasil en la década de 1990, la cultura de la pixação se consolidó aproximadamente dos décadas antes, lo que le aseguró la existencia hasta la actualidad.

Planteamos que la cultura graffitera brasileña se compone por dos culturas complejas que se articulan con la cultura del graffiti planetario; nos referimos a la cultura urbana alternativa de la pixação y a la cultura urbana alternativa del graffiti de escritores. La primera posee un carácter marcadamente nacional mientras que la segunda posee un carácter planetario: en la primera los resultados de las prácticas son exclusivamente firmas o tags, mientras que en la segunda la tipología de estilos abarca tags, bombas, piezas, wildstyle, caracteres, producciones, etc.

Referencias

- Haidar, J. (2006). Debate CEU-Rectoría. Torbellino pasional de los argumentos. Ciudad de México: UNAM. Recuperado de http://www.posgrado.unam.mx/publicaciones/ant_col-posg/31_Debate_CEU.pdf.

-

Pedroza, M. (2010). Identidades urbanas de taggers y graffiteros: análisis transdisciplinario de la producción semiótica del graffiti en el Distrito Federal. Ciudad de México: ENAH/INAH. Recuperado de https://www.academia.edu/35991973/Identidades_Urbanas_de_Taggers_y_Graffiteros_An%C3%A1lisis_transdisciplinario_de_la_

producci%C3%B3n_semi%C3%B3tica_del_graffiti_en_el_Distrito_Federal. - Pedroza, M. (2012). Semiosis visual en el graffiti de escritores: Producción cultural urbana alternativa. Ciudad de México: ENAH/INAH. Recuperado de https://www.academia.edu/35992064/Semiosis_visual_en_el_graffiti_de_escritores_Produccion_cultural_urbana_alternativa.

- Pedroza, M. (2016). La unitas multiplex del graffiti planetario: cultura urbana alternativa. Ciudad de México: ENAH/INAH.

- Pedroza, M. (2016). Pixação: protesta y transgresión . Discurso & Sociedad, 10 (2), 300-320. Recuperado de http://www.dissoc.org/ediciones/v10n02/DS10(2)Pedroza.pdf.

- Lotman, I. (1996). La semiosfera. I. Semiótica de la cultura y del texto Navarro, D. Sel. y Trad. Madrid: Cátedra. Recuperado de http://culturaspopulares.org/populares/documentosdiplomado/I.%20Lotman%20-%20Semiosfera%20I.pdf.

- Morin, E. (1999b). Los siete saberes necesarios para la educación del futuro, UNESCO.